Spätestens seit Amazons Vormarsch ist es auch allen Verlagen deutlich geworden, dass die Kundendaten das gewichtige Pfund sind, mit dem gehandelt wird. Welcher Kunde was gelesen hat und wofür er Geld ausgibt und welche Vorlieben sich aus seinem Medienverhalten ableiten lassen – das lässt sich monetarisieren. Aber ist es auch wirklich ein Thema und eine Aufgabe für Verlage oder doch für Dienstleister und global agierende Unternehmen?

Spätestens seit Amazons Vormarsch ist es auch allen Verlagen deutlich geworden, dass die Kundendaten das gewichtige Pfund sind, mit dem gehandelt wird. Welcher Kunde was gelesen hat und wofür er Geld ausgibt und welche Vorlieben sich aus seinem Medienverhalten ableiten lassen – das lässt sich monetarisieren. Aber ist es auch wirklich ein Thema und eine Aufgabe für Verlage oder doch für Dienstleister und global agierende Unternehmen?

The Big Data Journey – Definition, Bewertung und Ausblick

Eine schnelle Runde Buzzword-Bingo: Internet of Things, Smart Grid, Smart Cities, Smart Metering, Social Media, Social Recommendation, Social Commerce, mCommerce, Realtime (Re-)Targeting, Website Tracking, Customer Journey, Mobile Payment, Location Based Services. BINGO!

Was sich wie ein buntes Panoptikum der Berater-Phrasen liest, hat dennoch einen gemeinsamen technologischen Kern: In all diesen Zusammenhängen entstehen unglaublich große Datenmengen unterschiedlicher Art, die in irgendeiner Weise „wert“-voll sind. Das Problem: ihren Wert geben diese Daten nicht von alleine frei. Es braucht Grips und Technologie, um den (vermuteten) Schatz zu heben. Eine weitere vermeintliche Phrase kommt damit ins Bild: BIG DATA! Ein Hype oder ein ernstzunehmendes Thema?

Lassen wir uns die Dinge der Reihe nach betrachten: 1. Was ist „Big Data“ – und was nicht? 2. Wie macht man aus großen Datenmengen sinnvolle Informationen? 3. Welcher Wert steckt tatsächlich in diesem ominösen neuen Feld?

1. Was ist „Big Data“ – und was nicht?

Ob wir etwas groß oder klein finden ist eine sehr subjektive Angelegenheit. Wenn ein Freund uns von seinem großen neuen Haus berichtet, hat jeder von uns seine ganz eigene Vorstellung davon – je nach eigenem Bezugsrahmen und Erfahrungshorizont.

Ab wann also sind Datenmengen objektiv so groß, dass man von BIG Data spricht?

Dazu muss man zunächst mal wissen, woher der Begriff und die zugehörigen Methoden und Tools eigentlich kommen:

Immer dann, wenn Naturwissenschaftler oder ITler mit Datenmengen konfrontiert sind, die sich mit vorhandener Rechenleistung nicht mehr oder nicht mehr wirtschaftlich sinnvoll bearbeiten lassen, dann kommen wir in die Nähe von Big Data. Dies kann der Fall sein, wenn große Datenmengen von großer Unterschiedlichkeit in kurzer Zeit erzeugt werden. Beispiele gefällig?

- Auf Twitter entstehen pro Sekunde 60 MB neue Daten, das sind 5 TB (5.000 GB) pro Tag

- Bei Sonar-Messungen zur Öl-Eploration generieren 100.000 Sensoren 30 GB pro Sekunde

- Die Sensoren des Elektronenbeschleunigers im CERN würden sogar bis zu 1 Petabyte (also 1.000.000 GB!) Daten pro Minute erzeugen, wenn man diese Menge verarbeiten könnte!

Es sind also vor allem Physiker, Astronomen, Genetiker, Social Media- und andere Web-Firmen, die sich seit einigen Jahren mit der Frage befassen, wie diese großen Datenmengen gehandhabt werden können. Sie sind es auch, die sich um die neuen Technologien und Verfahren in diesem Feld verdient gemacht haben.

Nicht nur durch die o.g. Beispiele steigt derzeit die Datenmenge, die die Menschheit kontinuierlich generiert schneller an, als die Rechnerkapazität. 90% der Daten der Welt sind nicht älter als 2 Jahre. In dieser Zeit hat sich die theoretische Rechnerkapazität -dem Moore’schen Gesetz folgend- zwar auch mehr als verdoppelt, aber selbst wenn sich dies direkt in installierter Rechnerleistung niedergeschlagen hätte (Investitionszyklen ignorierend), reicht das nicht aus, um mit dem Datenwachstum Schritt zu halten.

Einen weiteren Aspekt darf man bei Big Data nicht außen vorlassen: Die Unterschiedlichkeit der Daten. Solange größere Datenmengen in einer gut strukturierten und bekannten Form vorliegen, lassen sie sich mit bewährten Verfahren in tabellenartigen Strukturen speichern und relativ gut auswerten. Hier hat es in den vergangenen 15 Jahren im Übrigen auch schon tolle Fortschritte durch intelligente Indexierung und Komprimierung gegeben.

Wer sich also vorstellt, dass die vielen Gigabytes an Banktransaktionen, Telekommunikationsdaten oder E-Commerce Vorfällen schon zu BIG sind, um sie zu verarbeiten, der kann beruhigt sein – bewährte Business Intelligence (BI) Verfahren kümmern sich heute um solche Datenbestände.

Nein – erst wenn solche gut strukturierten Massendaten zusätzlich auf unstrukturierte Daten wie Fotos, Kommentare und Tweets treffen oder Datenströme ins Spiel kommen, deren Struktur wir vorher noch nicht wirklich gut kennen (Sensordaten, Surfverhalten, Wetterinformationen etc.), dann sind wir im Land von BIG DATA.

2. Wie macht man aus großen Datenmengen sinnvolle Informationen?

Während in den traditionellen BI-Umfeldern durch Aggregation und Indexierung sinnvolle und handhabbare Informationen aus den Rohdaten gewonnen werden, geht die Modellierung bei BIG DATA in der Regel von vorab zu formulierenden Hypothesen aus. Was heißt das? Wenn die Physiker am CERN z.B. auf der Suche nach dem berühmt-berüchtigten Gottes-Teilchen (dem Higgs-Boson – sie scheinen es ja nun gefunden zu haben) sind, dann haben sie vorab ein relativ gutes Bild davon, wie die Sensordaten aussehen müssten, die ein solches Teilchen erzeugt. Mit einem solchen Muster geht man dann auf die Suche im großen Datentopf.

Durch Algorithmen wie dem von Google entwickelten „MapReduce“ wird nun diese Mustererkennung in viele kleine Teilprobleme zerlegt, die auf verteilten Rechnern autonom bearbeitet und in Millisekunden wieder zu einer Gesamtlösung zusammengesetzt werden können. Mit Apaches Open Source Software „Hadoop“ lässt sich so eine Problemlösung sogar relativ kostengünstig (wenn man Zugriff auf Hardware hat) und elegant (wenn man ein Brain ist, das den Algorithmus auch versteht) implementieren.

Zu Risiken und Nebenwirkungen lesen Sie bitte die einschlägigen wissenschaftlichen Veröffentlichungen (Mein Gott, was sind diese Wissenschaftler doch mitteilungsbedürftig!) oder fragen Sie Herrn Google oder Facebook (die beide massiv Gebrauch von dieser Technologie machen)!

Ein P.S. sei hier noch erlaubt: Wie immer bei neuen Technologien sind auch schon einige Kritiker auf den Plan getreten. Worüber diese vor allem nörgeln: MapReduce und seine Verwandtschaft sind derzeit nur für sehr spezifische Probleme einsetzbar. Im Prinzip muss man vorher schon das Ergebnis seiner Analyse kennen (z.B. die ungefähren Eigenschaften des Higgs-Bosons), um die Antwort in den großen Datenmengen auch zu finden. Nur so lässt sich der Algorithmus entsprechend justieren.

Anders formuliert: Wenn Facebook wissen will, wie viele Menschen Paris Hilton erwähnt, angeschaut oder ignoriert haben, dann finden sie die Antwort auf diese Frage auch für 900 Millionen Nutzer blitzschnell. Wenn Mark Zuckerberg aber rausfinden will, wie mehr Werbe-Milliarden aus den willenlosen Datenversorgern, genannt Nutzer, extrahiert werden können, dann schaut der kleine Hadoop-Elefant (das Logo der Software) ziemlich betreten drein.

Diese –zugegebenermaßen ziemlich weit hergeholte- Analogie führt uns nun nahtlos zu der Frage:

3. Welcher Wert steckt tatsächlich in diesem ominösen neuen Feld?

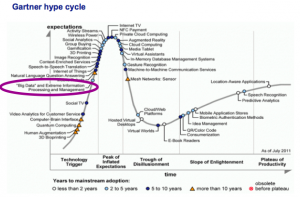

Lassen wir also zunächst kluge Menschen zu Wort kommen: Die Open Source Analysten von Wikibon sehen den Markt für IT-Leistungen rund um Big Data in 5 Jahren von rd. 5 Mrd. US$ auf mehr als das Zehnfache ansteigen. Gartner’s berühmter „Hype Cycle“ sieht das Thema in 2-5 Jahren im Mainstream ankommen. IBM –neben vielen anderen Großen der Zunft- hat sich Big Data als eines der Top-Themen auf die strategische Agenda geschrieben. Es muss also was dran sein am Big Business mit Big Data.

Eines sollte man nach meiner Einschätzung aber klar im Blick haben: Die heutigen Anwendungsfelder und Showcases, die durch die Medien geistern, sind allesamt Individual-Entwicklungen und stecken noch in den Kinderschuhen.

Sicher ist es spannend, wenn HSBC durch Big Data Anwendungen in der Lage ist, vor der Autorisierung einer Kreditkarten-Transaktion (also in Echtzeit) die Wahrscheinlichkeit eines Fraud-Falles zu errechnen (und ggf. die Autorisierungwegen möglicher betrügerischer Aktivitäten zu versagen).

Sicher ist auch spannend, wenn Telekommunikations-Konzerne durch die Auswertung von Social Media Unterhaltungen, Call Center Beschwerden und Netzmessungen intelligenter und proaktiver Dienst am Kunden leisten können – AT&T, Vodafone und andere haben hier erste Projekte umgesetzt.

Ob die Controller dieser Unternehmen aber langfristig den Business Case für die erheblichen Investitionen in die entsprechenden Systeme, ihre Weiterentwicklung und ihren Betrieb darstellen können, dazu lässt sich heute noch wenig sagen.

Fazit

Der Versuch eines Fazits: Big Data steht noch am Anfang seiner Entwicklung – sowohl technisch, als auch kommerziell – Was mittel- bis langfristig daraus werden kann ist daher unklar, aber es lässt sich manche Spannendes erwarten.

Durchaus selbstkritisch sei gesagt: Bevor Unternehmen Big Data als heiligen Gral für die Perfektionierung der Kundenbeziehung in den Himmel heben, könnten sie sich vielleicht zunächst noch einmal die Verbesserungsmöglichkeiten ansehen, die sie heute bereits mit den bestehenden Instrumenten und Möglichkeiten in Händen halten – da geht auf jeden Fall noch Einiges!

Medienunternehmen haben im Vergleich zu anderen Branchen noch einige Hausaufgaben zu lösen, bevor sie sich an Big Data wagen können. Die eigenen Kundendaten erfassen, strukturieren und bewerten – das allein ist schon eine Aufgabe, die bisher nur wenige Fachverlage, Amazon oder Weltbild lösen. Daraus noch Rückschlüsse ziehen für künftiges Nutzerverhalten, das ist dann die Kür.

Und hier könnte die Kooperation mit anderen Anbietern von Interesse sein: Medienhäuser haben Informationen über ihre Kunden: Denn sie bieten viele Produkte an und sammeln dem folgend viele Daten.

Pingback: Kognitive Systeme | smart digits

Pingback: Content braucht Social Media zum Überleben | smart digits

Pingback: BMW, Avis, Apple. — mobilbranche.de